telegreat中文版下载

tokenizer.encode,tokenizerencode如何对中文编码

1、alist小雅替换token如下1首先,我们使用tokenizer的encode方法将句子转换为一个token序列,其中add_special_tokens=False表示不添加特殊的起始和结束标记2然后,我们使用tokenizer的convert_tokens_to_ids方法将新的token转。

2、5 在tv_assistantpy中添加以下代码来生成相关文章并以文本的方式返回 ```python from transformers import GPT2LMHeadModel, GPT2Tokenizer # 加载模型和tokenizer model = GPT2LMHeadModelfrom_pretrained。

3、selftokenizer=GPT2Tokenizerfrom_pretrainedmodel_pathselfdevice=device devicedefgenerateself,prompt,length=50,temperature=10input_ids=promptinput_id。

4、input_ids=tokenizerencodeprompt,return_tensors=#39pt#39output=modelgenerateinput_ids,max_length=100,do_sample=Truegenerated_text=tokenizerdecodeoutput0,skip_special_tokens=Trueprintgenerated_text```机。

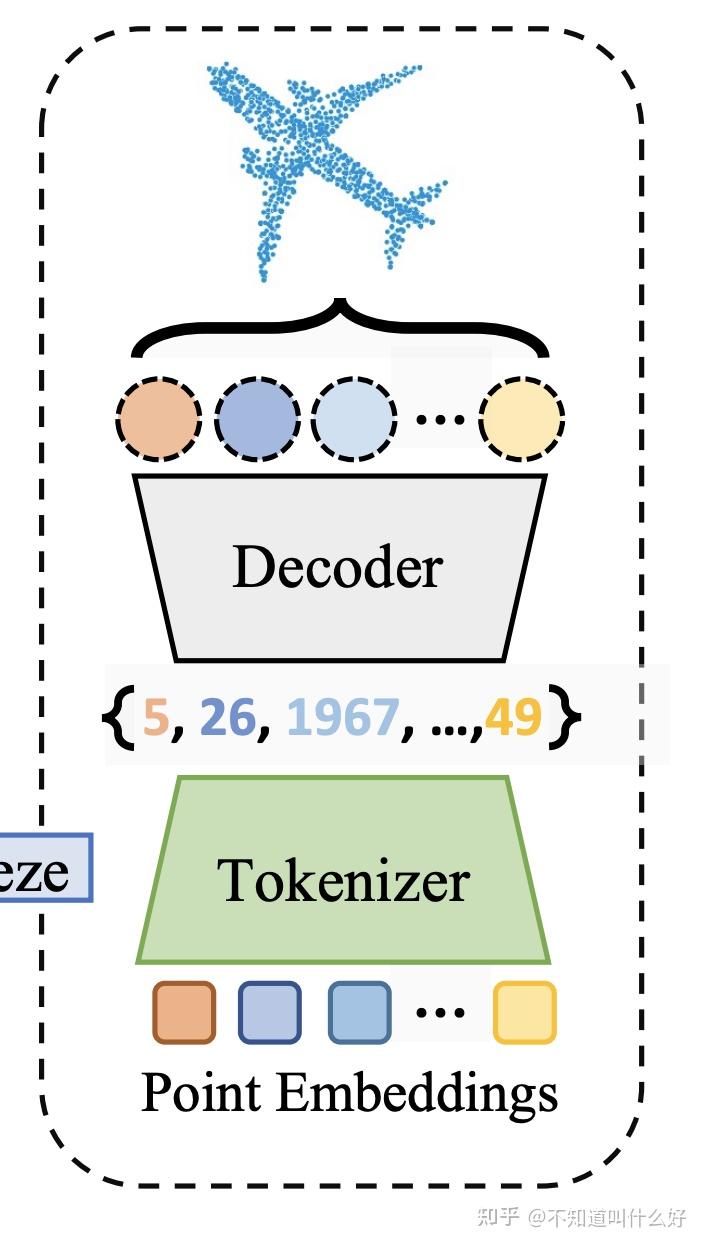

5、1一种解释 token令牌tokenize令牌化tokenizer令牌解析器 2另一种翻译是token可以翻译为“标记”,tokenize可以翻译为“标记解析”或“解析标记”,tokenizer可以翻译为“标记解析器”在编写词法分析器Lexer或。

6、StringTokenizer 是一个Java的类,属于 javautil 包,用来分割字符串和枚举类型StringTokenizer 构造方法1 StringTokenizerString str 构造一个用来解析 str 的 StringTokenizer 对象使用默认的分隔符空格quotquot。

7、请注意保存,以防失效,如果帮到你,请采纳。

8、Java中StringTokenizer分隔符可以是正则表达式 1136 Compile菜单 按Alt+C可进入Compile菜单, 该菜单有以下几个内容,如图所示1 Compile to OBJ将一个C源文件编译生成OBJ目标文件, 同时显示生成的文件名其。

9、情况是 我用 add_tokens方法 添加自己的新词后,BertTokenizerfrom_pretrainedmodel一直处于加载中原因 有说是词典太大,耗时hours才加载出来我也没有真的等到过暂时的解决办法参考于。

10、StringTokenizer st = new StringTokenizersrc, quot_quotwhile sthasMoreElements String s1 = stnextTokenif s1length 1 if s1equalsquotULquotsbappendquot_quotelse sbappends1。

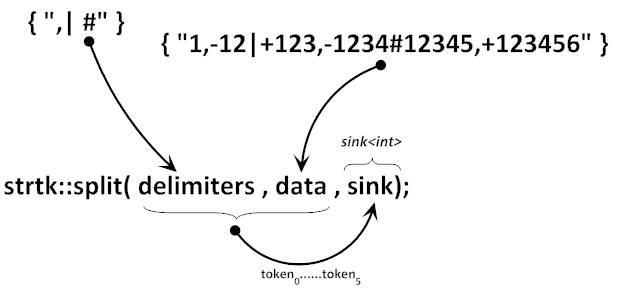

11、这是 StringTokenizer 类下的一个方法你首先要知道 StringTokenizer 是干什么用的StringTokenizer 用来分割字符串,你可以指定分隔符,比如#39,#39,或者空格之类的字符nextToken 用于返回下一个匹配的字段 给你一。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~